La ciencia de datos es un grupo colectivo de varios algoritmos, herramientas y principios de aprendizaje automático que funcionan al unísono para extraer patrones ocultos de datos sin procesar. Requiere un conjunto diverso de habilidades y exige conocimientos de aspectos de las matemáticas, la ciencia, la comunicación y los negocios. Al perfeccionar un conjunto diverso de habilidades, los científicos de datos obtienen la capacidad de analizar números e influir en las decisiones.

El objetivo central de los científicos de datos radica en cerrar la brecha entre números y acciones mediante el uso de la información para afectar las decisiones del mundo real. Esto exige excelentes habilidades de comunicación junto con la comprensión de la diferencia entre la ciencia de datos y el análisis de big data y las recomendaciones para las empresas.

VISUALIZACIÓN DE DATOS

Probablemente, una de las principales responsabilidades de un científico de datos es hacer que los datos sean lo más presentables posible para que los usuarios obtengan una mejor comprensión de los datos sin procesar y obtengan la información deseada de ellos. Las visualizaciones son importantes en primer lugar porque guían el proceso de pensamiento de las personas que las ven para un análisis más detallado. Se utilizan para crear historias de datos impactantes que comunican un conjunto completo de información en un formato sistemático para que las audiencias puedan extraer significado y detectar áreas problemáticas para proponer soluciones.

Sin herramientas de visualización de datos, sería prácticamente imposible implementar cambios o atender los problemas deseados. Hoy en día, existen muchas herramientas de visualización de datos para seleccionar. En la mayoría de los lenguajes de programación, encontrará bibliotecas que permiten la visualización de datos. En JavaScript, los datos se pueden visualizar usando la biblioteca de visualización D3.js, Python usa Matplotlib y pandas, mientras que R ofrece muchas herramientas de visualización de datos, incluido ggplot2.

Tableau es la plataforma de alto nivel con más tendencias que ofrece increíbles opciones de visualización de datos extrayendo datos de muchas fuentes diferentes.

LIMPIEZA DE DATOS

A menudo, los datos provienen de una variedad de fuentes y necesitan remodelación para poder derivar conocimientos informativos. Es importante que los datos estén libres de imperfecciones, como formato inconsistente, valores perdidos, etc. La manipulación de datos le permite llevar los datos a un nivel uniforme que se puede procesar más fácilmente. Obviamente, para que un científico de datos utilice los datos de la mejor manera, es importante poseer el conocimiento de cómo organizar datos limpios a partir de datos sin procesar inmanejables.

LENGUAJES DE PROGRAMACIÓN Y SOFTWARE

Los científicos de datos manejan datos sin procesar que provienen de una variedad de fuentes y en diferentes formatos. Dichos datos están llenos de errores ortográficos, duplicaciones, información errónea y formatos incorrectos que pueden confundir sus resultados. Para presentar correctamente los datos, es importante extraer los datos, limpiarlos, analizarlos y visualizarlos. A continuación se muestran seis herramientas de uso generalizado que se recomiendan encarecidamente para los científicos de datos:

- R: R es un lenguaje de programación que se usa ampliamente para visualización de datos, análisis estadístico y modelado predictivo. Ha existido durante muchos años y ha contribuido en gran medida a los analistas de datos con su enorme red (CRAN) que proporciona un paquete completo que permite a los analistas realizar diversas tareas relacionadas con los datos.

- Python: Python inicialmente no se consideraba una herramienta de análisis de datos. La biblioteca Python de pandas permite operaciones de procesamiento vectorizado y almacenamiento de datos eficiente. Este lenguaje de programación de alto nivel es rápido, fácil de usar, fácil de aprender y poderoso. Se ha utilizado para fines de programación general durante mucho tiempo y, por lo tanto, permite una fácil fusión de código de propósito general y procesamiento de datos de Python.

- Tableau: Recientemente surgido como una herramienta de visualización de datos asombrosa, Tableau, una empresa de software con sede en Seattle, ofrece un conjunto exclusivo de productos de alta gama que superan los recursos científicos como R y Python. Aunque Tableau carece de la máxima eficiencia en la remodelación y limpieza de datos y no ofrece opciones para cálculos procedimentales o algoritmos fuera de línea, se está convirtiendo cada vez más en una herramienta popular para el análisis de datos y visualizaciones debido a su interfaz altamente interactiva y su eficiencia en la creación de cuadros de mando dinámicos y atractivos. .

- SQL: Structured Query Language (SQL) es un lenguaje de programación de propósito especial que permite extraer y curar datos que se encuentran en sistemas de administración de bases de datos relacionales. SQL permite a los usuarios escribir consultas, insertar datos, actualizar, modificar y eliminar datos. Aunque todo esto también se puede hacer usando R y Python, escribir un código SQL genera una salida más eficiente y proporciona scripts reproducibles.

- Hadoop: Hadoop, un marco de software de código abierto que fomenta el procesamiento distribuido de grandes cantidades de conjuntos de datos utilizando algoritmos simples de grandes grupos de computadoras. Hadoop se utiliza principalmente en las industrias debido a su inmenso poder de cómputo, tolerancia a fallas, flexibilidad y escalabilidad. Permite modelos de programación como MapReduce que permiten el procesamiento de grandes cantidades de datos.

ESTADÍSTICA

Aunque hay muchas pruebas estadísticas automatizadas integradas en el software, un científico de datos debe poseer una sensibilidad estadística racional para aplicar la prueba más relevante para realizar interpretaciones orientadas a resultados. El conocimiento sólido del álgebra lineal y el cálculo multivariable ayuda a los científicos de datos a crear rutinas de análisis según sea necesario.

Se espera que los científicos de datos comprendan la regresión lineal, las relaciones exponenciales y logarítmicas y, al mismo tiempo, sepan cómo utilizar técnicas complejas como las redes neuronales. La mayoría de las funciones estadísticas las realizan computadoras en minutos, sin embargo, comprender los conceptos básicos es esencial para extraer todo el potencial. Una tarea importante de los científicos de datos consiste en obtener el resultado deseado de las computadoras y esto se puede hacer planteando las preguntas correctas y aprendiendo cómo hacer que las computadoras las respondan. La informática está respaldada de muchas maneras por las matemáticas y, por lo tanto, los científicos de datos deben tener una comprensión clara de las funciones matemáticas para poder escribir códigos de manera eficiente para que las computadoras hagan su trabajo a la perfección.

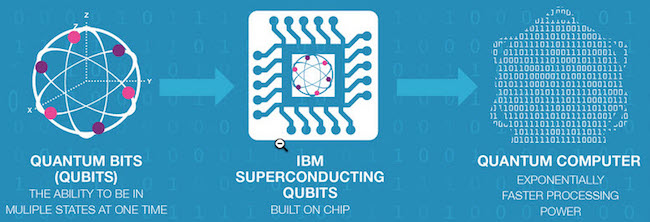

INTELIGENCIA ARTIFICIAL Y MACHINE LEARNING

La IA es el tema más popular en la actualidad. Potencia las máquinas al proporcionar inteligencia en el sentido real para minimizar la intervención manual a niveles extremos. El aprendizaje automático funciona con algoritmos automatizados para obtener reglas y analizar datos, y se utiliza principalmente en optimizaciones de motores de búsqueda, minería de datos, diagnóstico médico, análisis de mercado y muchas otras áreas. Comprender los conceptos de inteligencia artificial y aprendizaje automático para principiantes juega un papel vital en el aprendizaje de las necesidades de la industria y, por lo tanto, está a la vanguardia de las habilidades de ciencia de datos que debe poseer un científico de datos.

MICROSOFT EXCEL

Incluso antes de que existiera cualquiera de las herramientas modernas de análisis de datos, MS-Excel había estado ahí. Probablemente sea la herramienta de datos más antigua y popular.

Aunque ahora existen múltiples opciones para reemplazar MS-Excel, se ha comprobado que Excel ofrece unos beneficios realmente sorprendentes sobre otros. Le permite nombrar y crear rangos, ordenar / filtrar / administrar datos, crear gráficos dinámicos, limpiar datos y buscar ciertos datos entre millones de registros. Entonces, aunque pueda sentir que MS-Excel está desactualizado, déjeme decirle que no lo es en absoluto. Las personas sin conocimientos técnicos todavía prefieren usar Excel como su única fuente de almacenamiento y administración de datos. Es un prerrequisito importante para los científicos de datos tener un conocimiento profundo de Microsoft Excel para poder conectarse a la fuente de datos y seleccionar datos de manera eficiente en el formato deseado.

Oroginalmente publicado en: https://www.datasciencecentral.com/profiles/blogs/6-most-important-data-science-skills