Según una investigación reciente de PWC, el 72% de los líderes empresariales dijeron que creen que la IA será fundamental en el futuro y lo calificaron como una "ventaja comercial". Sin duda, la IA es una de las tecnologías futuras más importantes que muchas empresas, pequeñas o grandes, están optando rápidamente.

Con más de mil millones de usuarios activos de dispositivos con iOS y 2 mil millones de usuarios activos de dispositivos con Android, el sector de desarrollo de aplicaciones móviles personalizadas proporciona los mercados más rentables y cautivadores para desarrollar y vender las soluciones digitales más avanzadas a los usuarios de todo el mundo. Hay alrededor de 4 millones de aplicaciones móviles únicas en este sistema operativo, la mayoría de las cuales tienen funciones similares.

El aprendizaje automático es una parte crucial e integral de la Inteligencia Artificial que se usa ampliamente en los servicios de desarrollo de software. Además, tuvo un impacto en el desarrollo de aplicaciones móviles y se ha convertido en un mercado potencial para implementar software que pueda adaptarse al comportamiento del usuario.

Hoy en día, todos quieren una experiencia de usuario personalizada de acuerdo con sus necesidades específicas. Por lo tanto, no es suficiente desarrollar una aplicación móvil decente que satisfaga las necesidades de todo tipo de usuarios. Deje que el aprendizaje automático o la inteligencia artificial trabajen para usted. Las aplicaciones impulsadas por el aprendizaje automático pueden transformar sus aplicaciones móviles con las que los usuarios pueden soñar. Esto ha abierto el camino para algunas aplicaciones geniales.

Ahora, analicemos algunas ideas de aplicaciones móviles basadas en inteligencia artificial o aprendizaje automático en las que puede aplicar técnicas de aprendizaje automático:

IDEA 1: Aplicaciones basadas en IA para herramientas y equipos de atención médica

Para el año 2020, la inteligencia artificial tendrá un gran impacto en la industria de la salud. Las aplicaciones AI / ML ayudan a analizar los datos de los pacientes y también ayudan a mejorar los resultados. Esto significa que las aplicaciones basadas en IA pueden usarse como herramientas de mejora de decisiones que mejoran la confiabilidad, la previsibilidad, la calidad y la estabilidad del trabajo junto con la seguridad.

Echa un vistazo a algunos ejemplos:

1. BillyScreen es una aplicación móvil popular que utiliza herramientas de IA y ML, algoritmos de visión por computadora y cámaras inteligentes para detectar niveles aumentados de bilirrubina en la parte blanca del ojo humano. También se está utilizando para detectar diversas afecciones críticas de salud, como el cáncer de páncreas.

2. Redivus Health es una aplicación móvil intuitiva que muchos proveedores de atención médica utilizan ampliamente para evitar errores en los datos médicos. También proporciona apoyo ininterrumpido para la toma de decisiones clínicas durante eventos médicos documentados en tiempo real.

IDEA 2: Aplicaciones de servicios de TI basadas en inteligencia artificial

Con el creciente mundo digital, los ataques cibernéticos y los piratas informáticos se están convirtiendo en una realidad creciente. Una de las mejores ideas es usar inteligencia artificial o aprendizaje automático en soluciones de TI, seguridad y servicios para intervenir en la marca. Las empresas pueden crear plataformas de IA y aplicaciones móviles para servicios de TI y seguridad para diversas cargas de trabajo de sistemas informáticos.

Ejemplo:

AI2 es una plataforma basada en IA, desarrollada por el Laboratorio de Ciencias de la Computación, Patrón X e Inteligencia Artificial (CSIL) del MIT. Esta plataforma pretende predecir ataques cibernéticos con su modelado contextual proactivo que es un ciclo de retroalimentación continua entre un sistema de inteligencia artificial y un analista humano.

IDEA 3: Aplicaciones de comercio electrónico basadas en IA para vender productos

La tecnología de inteligencia artificial puede dar a los sitios web centrados en el cliente una ventaja competitiva y está disponible para una gran cantidad de empresas de comercio electrónico de cualquier tamaño o presupuesto. La inteligencia artificial y el aprendizaje automático ahora permiten a los compradores electrónicos asociar productos con el color, el tamaño, la forma y la marca correctos. Muchas aplicaciones web centradas en el cliente ya se están volviendo más sofisticadas con capacidades avanzadas de inteligencia artificial y se espera que crezcan en el futuro.

Aquí hay ejemplos de aplicaciones de comercio electrónico basadas en IA:

1. La aplicación Alexa más popular de Amazon es una herramienta de inteligencia artificial popular que ayuda a aprender los algoritmos de la base de marketing dirigida de Amazon. Alexa le permite a Amazon saber qué productos y servicios tendrán la mayor demanda de acuerdo con las búsquedas de los clientes y también compartir recomendaciones personalizadas.

2. eBay también utiliza inteligencia artificial para mantener una ventaja competitiva en el mercado. La plataforma eBay Shopbot es útil para encontrar diferentes productos utilizando NLP (procesamiento de lenguaje natural). Por lo tanto, está claro que el aprendizaje automático es una parte crucial de la estrategia comercial de eBay.

Del mismo modo, puede usar la función AI para hacer que sus aplicaciones de comercio electrónico tengan más funciones para sus clientes. Puede obtener soluciones de desarrollo de aplicaciones móviles para transformar su idea en realidad.

IDEA 4: Aplicaciones de ciberseguridad basadas en IA

La inteligencia artificial también tiene beneficios en ciberseguridad. Por un lado, la tecnología está capacitando a varias empresas para proporcionar una protección más inteligente y efectiva contra los ciberataques. La disponibilidad de marcos de código abierto basados en inteligencia artificial como TensorFlow, Caf y Torch fortalece y automatiza la seguridad de los datos a escala.

Aquí están algunos ejemplos-

1. LogRhythm está utilizando soluciones de seguridad de primer nivel para varias empresas para detectar y responder a diferentes amenazas de ciberseguridad. El perfil de aprendizaje automático de la compañía ayuda a detectar amenazas y otras anomalías en línea.

2. Una marca como CrowdStrike utiliza un software de seguridad de punto final basado en la nube, llamado Falcon, que ofrece prevención contra amenazas cibernéticas y proactivas en diversas industrias, como el comercio minorista, la atención médica y las finanzas.

IDEA 5: Aplicaciones de ahorro de energía, energía y costos habilitadas por AI

Con la tecnología AI y ML, los proveedores de electricidad pueden optimizar eficazmente la eficiencia de generación de energía y pueden ayudar a predecir futuras cargas de energía a niveles granulares. Por ejemplo, el concepto de un "parque eólico digital" de GE Renewable Energy comprende un software de inteligencia artificial que monitorea el movimiento de la turbina y ayuda a mejorar los niveles de generación de energía hasta en un 20%.

La aplicación móvil de Codegreen Energy está ahorrando miles de millones de dólares con su tecnología habilitada para IA de bajo consumo. La aplicación móvil compara la eficiencia de los niveles de energía de miles de edificios para determinar si cumplen con las leyes que muestran su puntaje Energy Star.

IDEA 6: Aplicación de narración de historias habilitada por AI

¿Te gusta escuchar historias o leer libros en la radio? Confía en mí, estas historias no siempre vienen como quieres, podrían deberse a un horario ocupado u otras razones. La aplicación móvil Storyteller se asegurará de que pueda escuchar sus libros o novelas favoritas, leerle en un formato de narración real.

Simplemente pegue el archivo PDF o Word de la historia o el enlace a la aplicación, y la aplicación móvil lo leerá no como un dictado sino como un narrador profesional. Esta aplicación móvil también predeterminará su estilo de narración basado en el análisis jerárquico de la historia recibida.

IDEA 7: Aplicaciones de automatización de reclutamiento en línea habilitadas por AI

La inteligencia artificial automatiza de manera efectiva el proceso de reclutamiento, como la selección, el reclutamiento de candidatos y la búsqueda de trabajo, por lo que es una de las buenas ideas de aplicaciones que se te ocurren. La tecnología basada en IA se enfoca en varias otras tareas de reclutamiento y reduce sus esfuerzos al buscar en Internet a los aspirantes correctos.

Hoy en día, los empleadores inteligentes utilizan ampliamente las aplicaciones móviles de reclutamiento habilitadas para IA para encontrar a los candidatos correctos que no han sido considerados para puestos de trabajo en el pasado, no porque estén bien calificados, sino porque aparecen en los resultados de búsqueda o no aparecieron.

Ejemplo:

El chatbot de reclutamiento es la mejor herramienta de reclutamiento habilitada para IA que utiliza lenguaje natural para comprender el texto ingresado por los usuarios. Una de las características principales de un chatbot de reclutamiento es ofrecer comunicación en tiempo real a los candidatos y programar una entrevista con el reclutador.

Existen herramientas basadas en inteligencia artificial que ayudan a comercializar los mejores canales de reclutamiento utilizando mensajes dirigidos, automatización y análisis habilitados por tecnología. En el año 2019, las herramientas de marketing de reclutamiento habilitadas para IA serán la mejor técnica para publicitar su empresa entre los candidatos para el trabajo.

IDEA 8: Aplicaciones de aprendizaje rápido habilitadas para IA

El concepto de IA o herramientas de aprendizaje automático ha cambiado la forma en que leemos, buscamos y escribimos texto. Existen aplicaciones avanzadas de inteligencia artificial o aprendizaje automático que lo entienden, buscan y leen, esto también ayudará a los investigadores a aprender sobre el desarrollo de la última tecnología, herramientas e información.

Ejemplos:

1.Udemy es uno de los mejores ejemplos de una aplicación móvil de aprendizaje que ofrece una amplia gama de cursos para desarrollo personal, desarrollo web y muchos más. También puedes aprender a tocar la guitarra, Udemy ofrece docenas de cursos para ayudarte.

2. Goodreads es también una de las mejores formas de aprender casi cualquier cosa sobre tecnología, ficción, autoayuda, etc. La aplicación cuenta con más de 40 millones de miembros registrados y en crecimiento. La aplicación ayuda a los usuarios a encontrar el libro correcto en el momento adecuado.

IDEA 9: Interfaces inteligentes de conversación habilitadas por AI

La interfaz interactiva es la última tendencia en esta era digital que se centra en cómo las personas interactúan con el sistema. Grandes marcas como Facebook, Amazon, Google y Microsoft están fuertemente enfocadas en el desarrollo de diferentes interfaces de conversación.

Ejemplos:

1. La aplicación móvil de Starbucks para iPhone es un buen ejemplo de una interfaz de conversación que le otorga recompensas, le permite interactuar con chatbots y puede buscar en las tiendas. El asistente virtual que usan es “My Starbucks Barista, una tecnología basada en inteligencia artificial que también puede aclarar los elementos del menú y los precios.

2. Otro ejemplo popular es el chatbot de Bank of America llamado Erica, que ayuda a los clientes del banco a tomar decisiones financieras como balancear cheques, hacer pagos, analizar gastos y hacer sugerencias. Los usuarios pueden descargar fácilmente Erika a sus teléfonos móviles y chatear a través de mensajes de voz o de texto.

IDEA 10: Aplicaciones de predicción de mercado habilitadas por AI

Ahora en estos días, los operadores del mercado deben actualizarse en cada paso del mercado. El uso de la IA o la aplicación de aprendizaje automático en el mercado de valores moderno hace que las acciones suban y bajen diariamente. También puede obtener ayuda para crear una cartera, verificar el valor de mercado en tiempo real de cualquier acción, obtener ayuda para comprender los gráficos de acciones, las tendencias del mercado y todo desde su teléfono móvil.

Ejemplos:

1. Para actualizaciones del mercado en vivo, NetDania Forex es una de las mejores aplicaciones que le envía cotizaciones en bolsas mundiales, pares de divisas y productos principales. Esta aplicación móvil le envía notificaciones en vivo cuando se publican datos económicos.

2. FRED Economic Data es una de las mejores aplicaciones para aquellos que no están familiarizados con los datos económicos, que es un repositorio en su teléfono móvil con miles de series temporales para varios puntos de datos económicos en todo el mundo.

IDEA 11: Predicción basada en IA para la explotación de vulnerabilidades

La IA o las aplicaciones de aprendizaje automático son una gran idea para predecir cuándo los atacantes utilizarán cualquier vulnerabilidad particular en una parte de las aplicaciones de software. Esto también nos permite tener días o incluso semanas antes de nuevos ataques.

Este es realmente un problema poderoso, pero al centrarnos en una simple clasificación de "será atacado" o "no será atacado", podemos entrenar fácilmente el modelo exacto con un alto recordatorio.

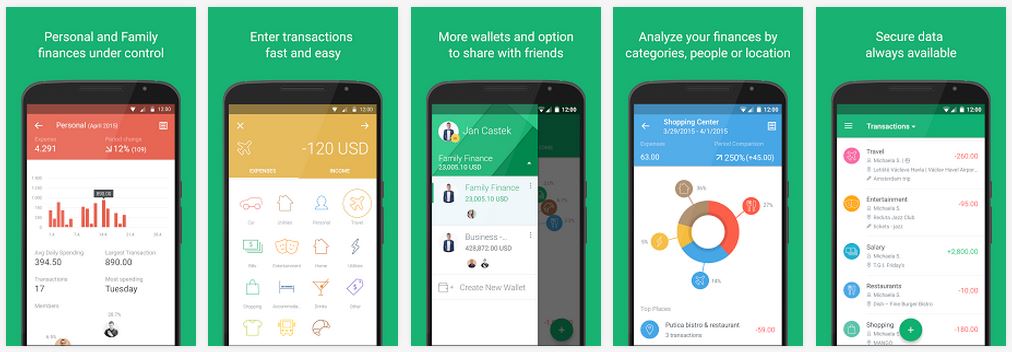

IDEA 12: Aplicaciones de contabilidad y finanzas habilitadas por IA

La inteligencia artificial o las características de aprendizaje automático están afectando a muchas industrias y las industrias de fintech y contabilidad no son una excepción. Hoy en día, los profesionales de finanzas y contabilidad están utilizando inteligencia artificial o aprendizaje automático para facilitar su trabajo a través de prácticas como la entrada rápida de datos y los informes.

Eche un vistazo a algunos ejemplos:

1. Las aplicaciones móviles de contabilidad cero aceleran la ejecución de la información financiera y envían actualizaciones en vivo sobre los datos bancarios, la facturación, el flujo de caja y más.

2. VOD es un sistema POS popular y fácil de usar que envía actualizaciones financieras directamente a los consumidores desde tiendas o tiendas. Esta plataforma también tiene excelentes capacidades de informes.

Conclusión

Por lo tanto, hemos visto una lista de ideas de aplicaciones de inteligencia artificial o aprendizaje automático que definitivamente ayudarán a que su negocio crezca bien. En el año 2020, la inteligencia artificial se ha convertido en herramientas poderosas para todo tipo de empresas. Aunque las grandes corporaciones han sido líderes en el uso del aprendizaje automático y la inteligencia artificial, una gran cantidad de pequeñas empresas ya están utilizando estas tecnologías para mejorar su competitividad a través de la eficiencia, la innovación y la productividad.

Si es una empresa y desea tener su propia aplicación habilitada para IA, puede elegir una compañía de desarrollo artificial que brinde soluciones de aplicaciones repletas de funciones en IA. Hay muchas compañías que ofrecen servicios de desarrollo de aplicaciones móviles habilitados para IA en India. Puede elegir el mejor y construir su aplicación móvil.

Fuente: https://towardsdatascience.com/12-best-ai-ml-based-app-ideas-thatll-make-money-in-2020-96d104b6367e